SQC

ビッグデータ時代におけるものづくり品質革新1-デンソーにおけるデータサイエンス教育の実際-<2015年11月06日>

■はじめに

近年、各方面から注目を集めているビッグデータだが、現状はシステム的な側面だけが先行し、企業にとって投資に見合った成果を引き出しているかは疑問である。これは、解析者である「データサイエンティスト」と呼ばれる人材が育っていないからに他ならない。

そんな中、NECの藤巻氏による「異種混合学習による異常検知」(これは数々の学会賞を総なめにした画期的な手法である)や、IBMの井手氏による「スパース構造学習による異常検知」など、先進的な企業では大きな成果を挙げつつあり、彼我の差は開く一方である。これらは、優秀なデータサイエンティストを擁することが成果につながる典型例といえる。

ビッグデータを活用した品質革新は、上記の最新研究を見れば分かるように、「IOTによる障害予兆検知」によって、徹底的にロスを無くしていくことで実現される。これは、独のインダストリー4.0が目指している世界でもある。

このように、日本の製造業の競争力向上には不可欠なビッグデータ活用であるが、あらためて述べるまでもなく、実態は上記の理由から殆ど進んでいない。

ビッグデータのような大量の情報を解析するには、データサイエンスと呼ばれる知識(ベイズ統計学、正則化法やカーネルトリックなど)が必要であるが、その理解は非常にハードルが高い。なぜなら、専門書は多数出版されてはいるが、いずれも内容は高度で、初学者の知識とのギャップが大きいし、ネットの情報は、いわゆるオタク的な内容で、そこから体系的な知識を得ることは難しいからである。

■技術者の期待

製造業において解析対象となるビッグデータは、主なものとしては、工場では、製造工程の加工条件や検査データなどがある。これらはトレーサビリティの観点から自動的に採取され保存されている。また、実験室では、設計者はデータロガーを通じて大量のデータを手にしている。

しかし、データがいかに巨大化しようとも、技術者のデータ解析に対する期待は変わらない。

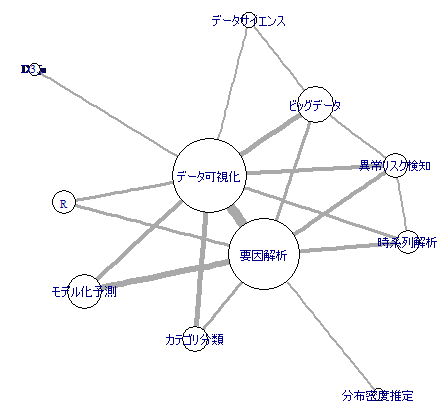

図1は、筆者が担当する社内セミナーにて、参加者の関心事についてアンケートを取った結果であるが、これを見れば分かるように、技術者は要因解析とデータ可視化に強い関心がある。技術者にとってデータ利活用は、具体的な仕事や技術に関する解を満たす手段なのである。

図1.技術者の関心語の共起ネットワーク

要因解析手法として用いられるのが、グラフィカルモデリングや重回帰分析であり、これらはSQCの基本として入社時から教えられ日常的に利用されている。重回帰分析は、今や表計算ソフトで近似式のメニューとして提供されているくらい一般的である。一方のグラフィカルモデリングは、あまり一般的ではないが、変数間の関連性を表すとされる相関係数には疑似相関が含まれるため、それを取り除いた偏相関係数の行列をグラフとして図示する方法である。

疑似相関については、間違いのもとであると教え込まれ、常に注意が払われている。巷で喧伝されるビールとおむつの売れ行きの関連性も疑似相関である。おおかた車で来店しているか否かという因子を介して関連性が出てきていると思料され、来店手段を固定すると、その関連性は消えてしまう。

グラフィカルモデリングは、このような疑似相関を取り除いた関係を図示するので、要因解析にとってはありがたいツールである。

これらは、いずれも古典的なSQC手法である。

世間でデータサイエンスと称して教えられているのは、実はこのような古典的なSQC手法であったりする。これはビッグデータの普及の対象が、最初は第3次産業であったことに起因しているのかもしれない。そこでは、重回帰分析ですら新鮮に受け止められている。

それに対して、技術者の間では、重回帰分析などのSQC手法は、入社数年目までに必須教育で教え込まれ、日常業務で普段から使用されるツールである。(近似線を入れる処理として技術者なら誰もが一度は使用した経験があるだろう。フリーハンドで近似線を入れる技術者はいないと思われる)

これから考えると、今日データサイエンティストが不足しているというような議論は無用かもしれない。もしデータサイエンティストに必要な知識が重回帰分析程度でよいのなら、技術者は全てデータサイエンティストと言えるからである。

ところが、ビッグデータに対しては、この便利なSQCツールがうまく機能しない。ビッグデータは、もちろん大標本であるが高次元という特徴もある。高次元ゆえ予期せぬ線形制約もある。線形制約があると、古典統計の基本であるXTXの逆行列が求められないという問題が生じるためである。問題点は、古典統計の殆どがXTXの逆行列を計算式に含んでいるということである。(重回帰分析やグラフィカルモデリングの式も同様である)。技術者は、高次元大標本に対応したデータサイエンスの手法を学ぶ必要が出てきたということができる。

■これからの技術者が学ぶべき内容

今私たちが用いているSQC手法は100年も前に確立された手法である。当然、少数サンプルが前提であり、巨大データには対応できない。21世紀の統計は、巨大データに対応する。今主流となっているのは、カーネルトリックと正則化、それとベイズ統計学である。

カーネルトリックとは、今あるデータから非線形関数でさらにデータを作って高次元の空間を作り出す手法である。高次元に写像することによって、データ間はスパース(疎)になり、線形判別のための境界平面を差し込みやすくなる。これがサポートベクターマシーンと呼ばれる判別分析の手法である。

正則化とは、まさにXTXを、逆行列が存在するように変形することである。前にも述べたように、予期せぬ線形制約が存在しても、正則化することにより重回帰分析やグラフィカルモデリングが解けるようになる。

ベイズ統計学は、古くから存在するが、今日流行しているのはノンパラベイズであり、ディリクレ分布を事前分布とする多項分布に適用されている。これは、いわゆる潜在的ディリクレ配分(LDA)として、トピックモデル分析に利用される。だが、工業的には状態空間モデルに適用される動的線形方程式に用いられるベイズ的なフィルタ(カルマンフィルタや粒子フィルタ)の方が関心が高いかもしれない。

昨今、ネットなどを見渡すと、一部の上級データサイエンティストたちが、これらをプログラム上に実装して、解析結果を披露しているが、一般的な技術者の期待から掛け離れ、数年先のレベルまで行っている。

次回は,デンソーにおける取り組みとまとめをお送りします。

吉野 睦

(よしの むつみ)

(株)デンソー 品質管理部 TQM推進室 担当次長、博士(工学)

主な著書に『シミュレーションとSQC―場当たり的シミュレーションからの脱却 (JSQC選書)』(共著、日本規格協会、2009年)、『パラメータ設計・応答曲面法・ロバスト最適化入門―JUSE‐StatWorksオフィシャルテキスト (実務に役立つシリーズ)』(共著、日科技連出版社、2012年)

〈お問い合わせ先〉一般財団法人 日本科学技術連盟 品質経営研修センター 研修運営グループ

〒166-0003 東京都杉並区高円寺南1-2-1 / TEL:03-5378-1213

Copyright © 2021 Union of Japanese Scientists and Engineers. All rights Reserved.